如何优雅的、本地化、运行Meta最新的大模型Llama 3.1

条评论

目前大模型层出不穷,刚好最近 Meta 发布了最新的 Llama 3.1,各方面性能表现都不错,今天介绍一个本地使用开源大模型的方法。

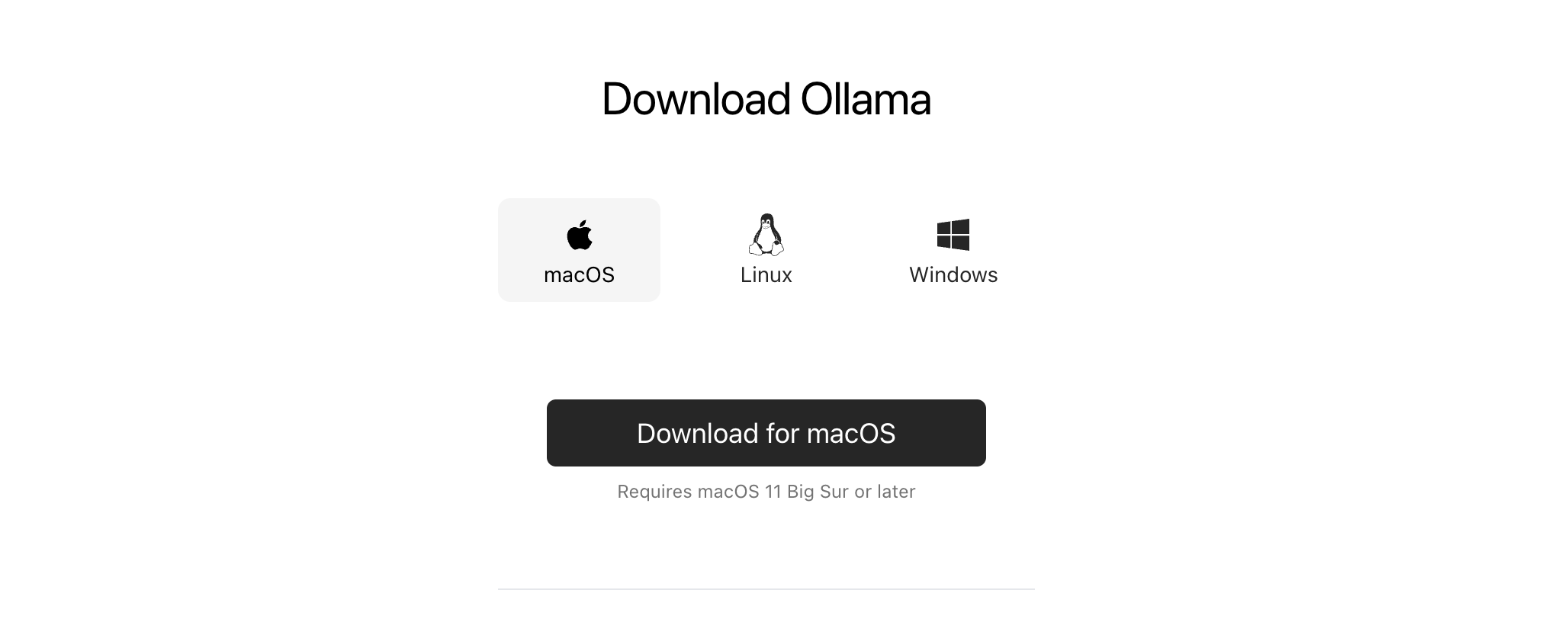

安装 Ollama

打来 ollama 的官网,https://ollama.com/download 安装主程序。

下载模型

运行下面的指令,即可开始下载模型,当然,打开 https://ollama.com/library 可以获取到更多开源大模型。

1 | ollama run llama3.1 |

摆脱命令行

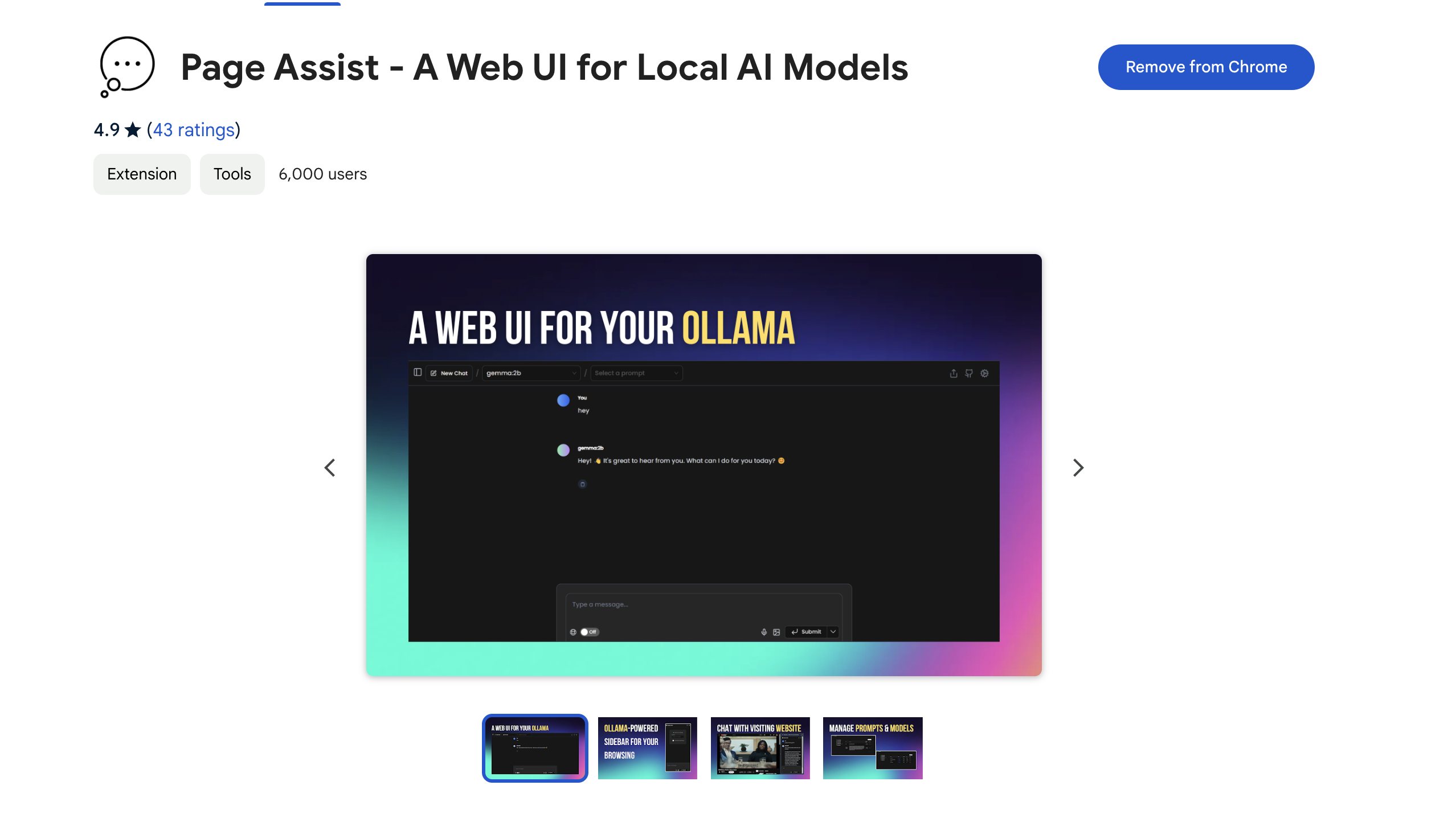

方案一:使用 Chrome 插件。Page Assist - A Web UI for Local AI Models

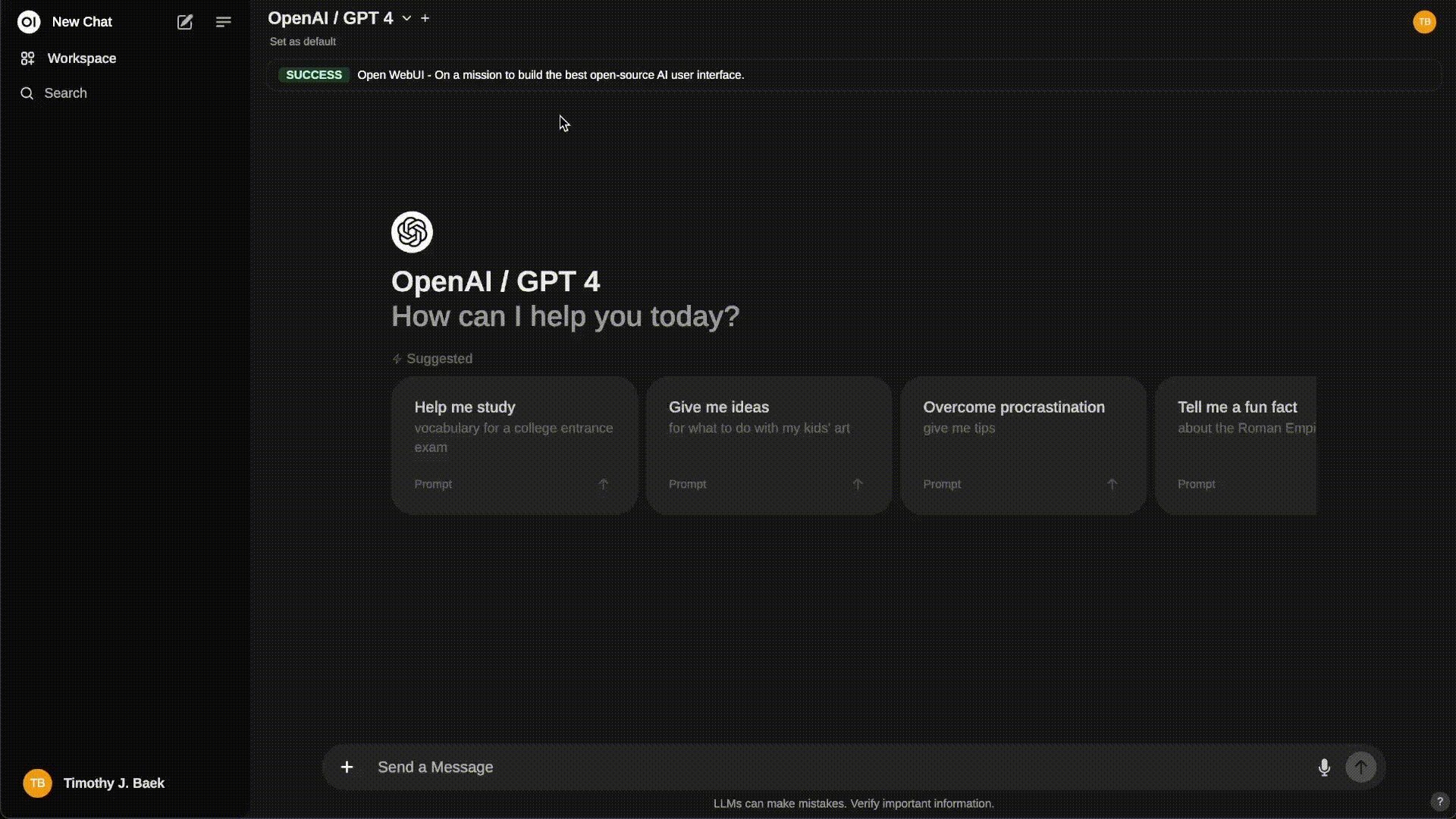

方案二:自己部署 Open WebUI