如何在app上使用ollama,以及模型推荐

条评论

上一期和大家介绍了如何在本地电脑上使用浏览器插件的方式运行 Llama 3.1 的大模型,今天给大家推荐一个 App 的客户端。目前只支持 Mac 和 iPhone,Enchanted

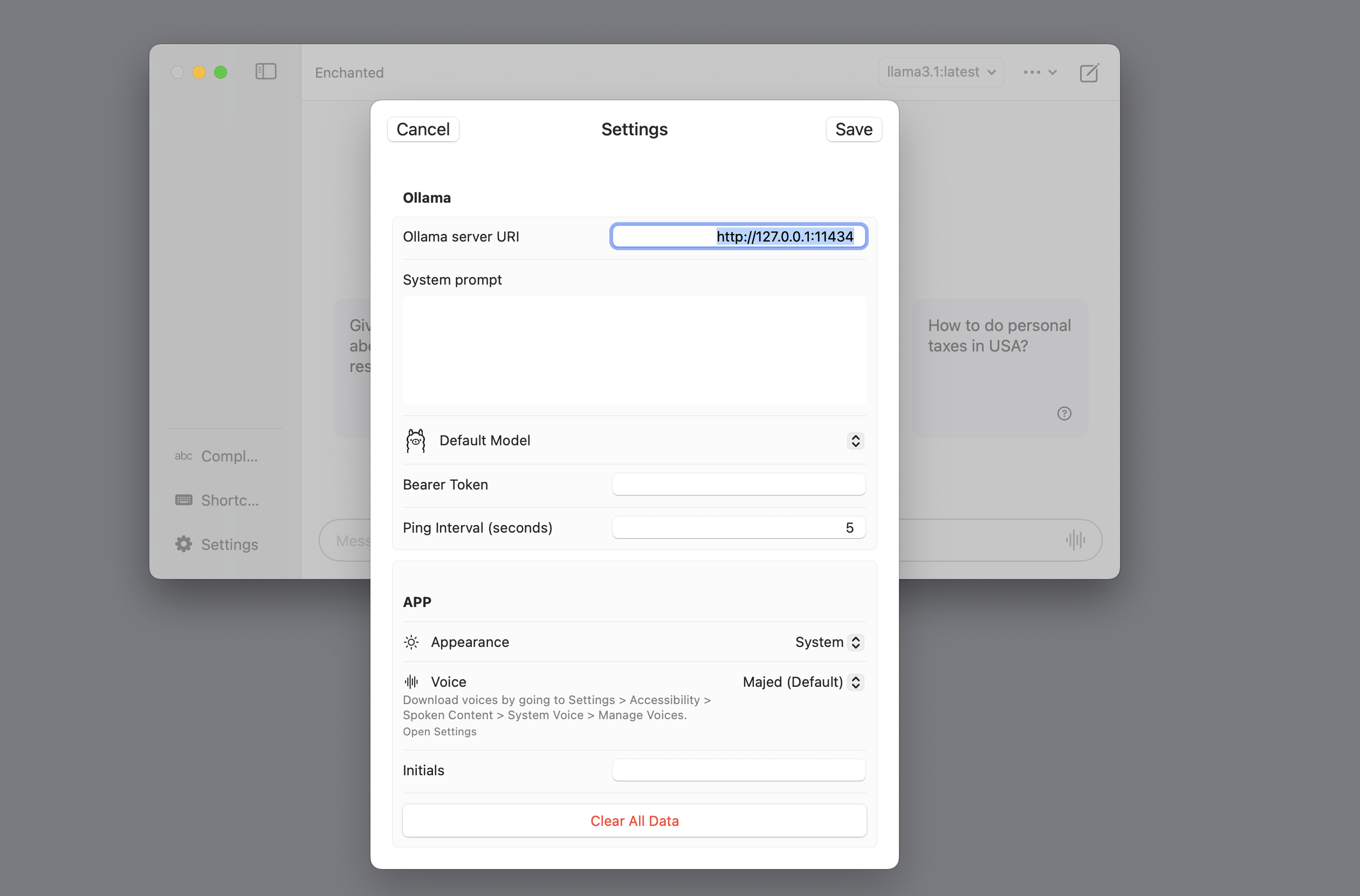

配置服务地址

输入本地的 Ollama 地址,一般默认:http://127.0.0.1:11434

选择一个自己喜欢的模型。

推荐模型

最新的文本聊天模型,Llama 3.1

1 | ollama run llama3.1 |

可以识别图片的模型,这个模型也不大,4.7 G

1 | ollama run llava |

文本嵌入模型

1 | ollama pull nomic-embed-text |

中文能力比较好的模型

1 | ollama run qwen2 |

数学能力比较好的模型

1 | ollama run mathstral |

手机上使用

- stop the ollama application;

- run

launchctl setenv OLLAMA_HOST "0.0.0.0" - restart ollama