Mac上的本地大模型的客户端简单介绍

条评论Mac 上有很多本地大模型客户端,Chatbox、LM studio、Chatwise、Opencat、 Cherry Studio。这里做一些简单的介绍,不算很复杂的评测,只是简单说说不同,你可以随便挑一个你喜欢的用。

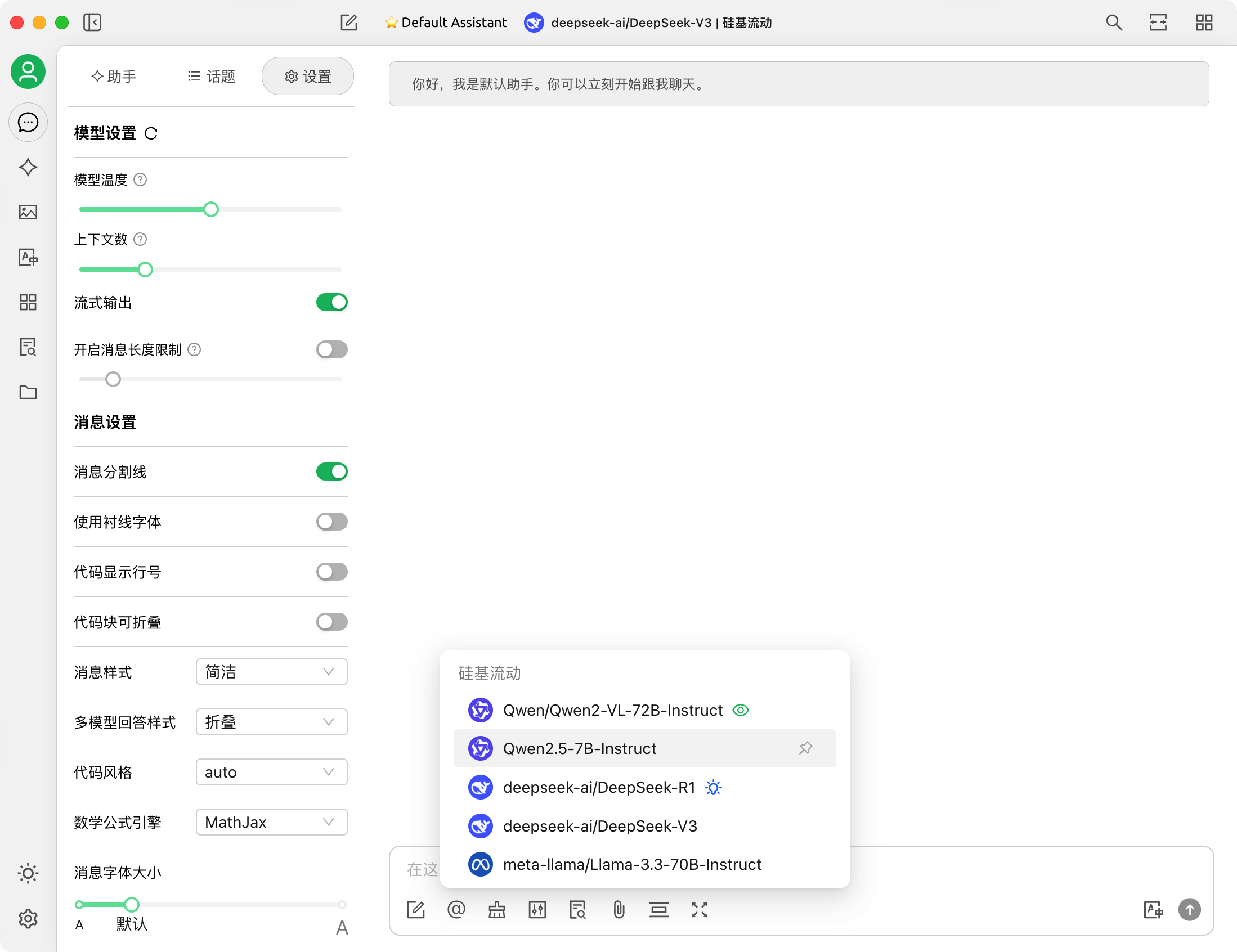

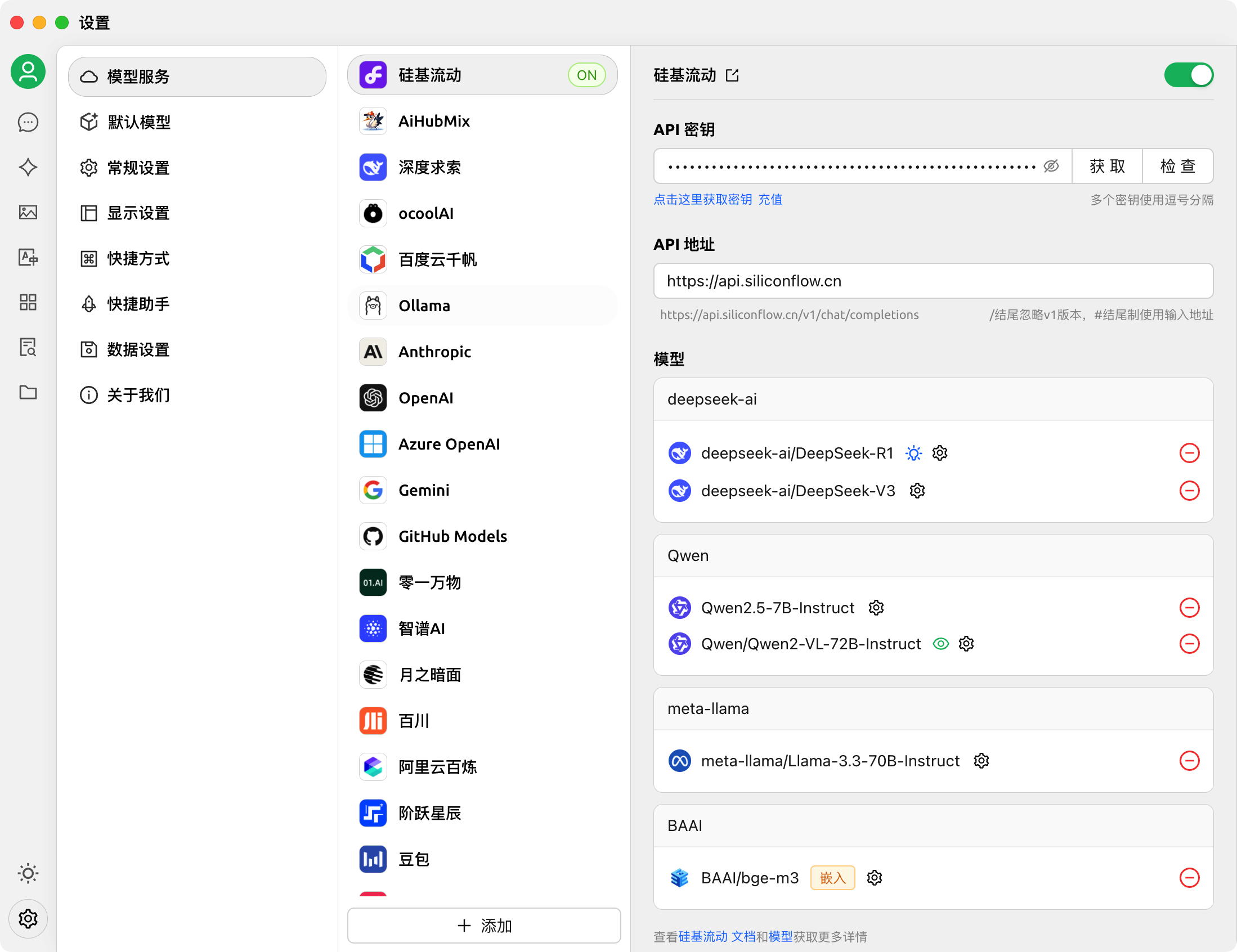

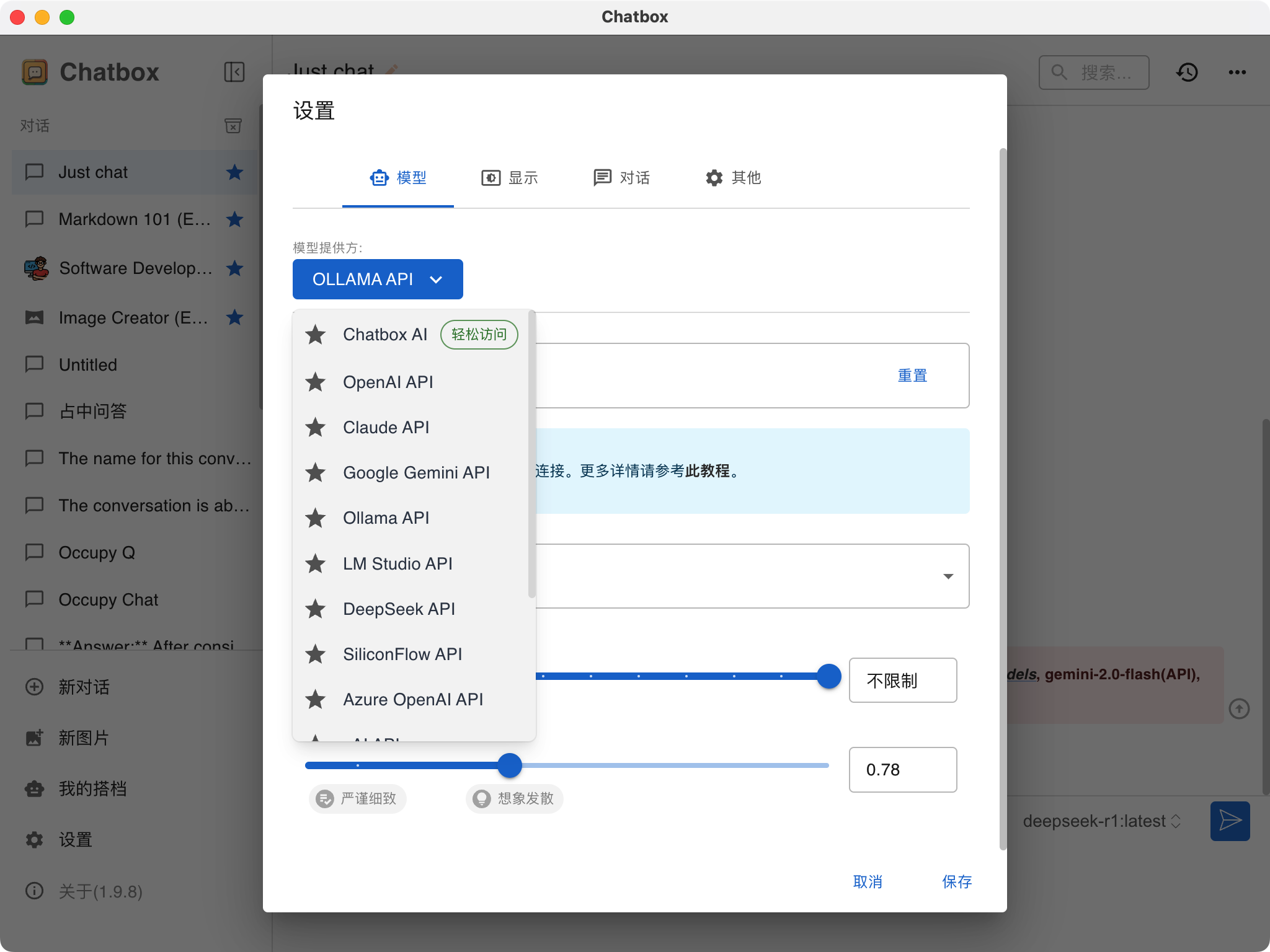

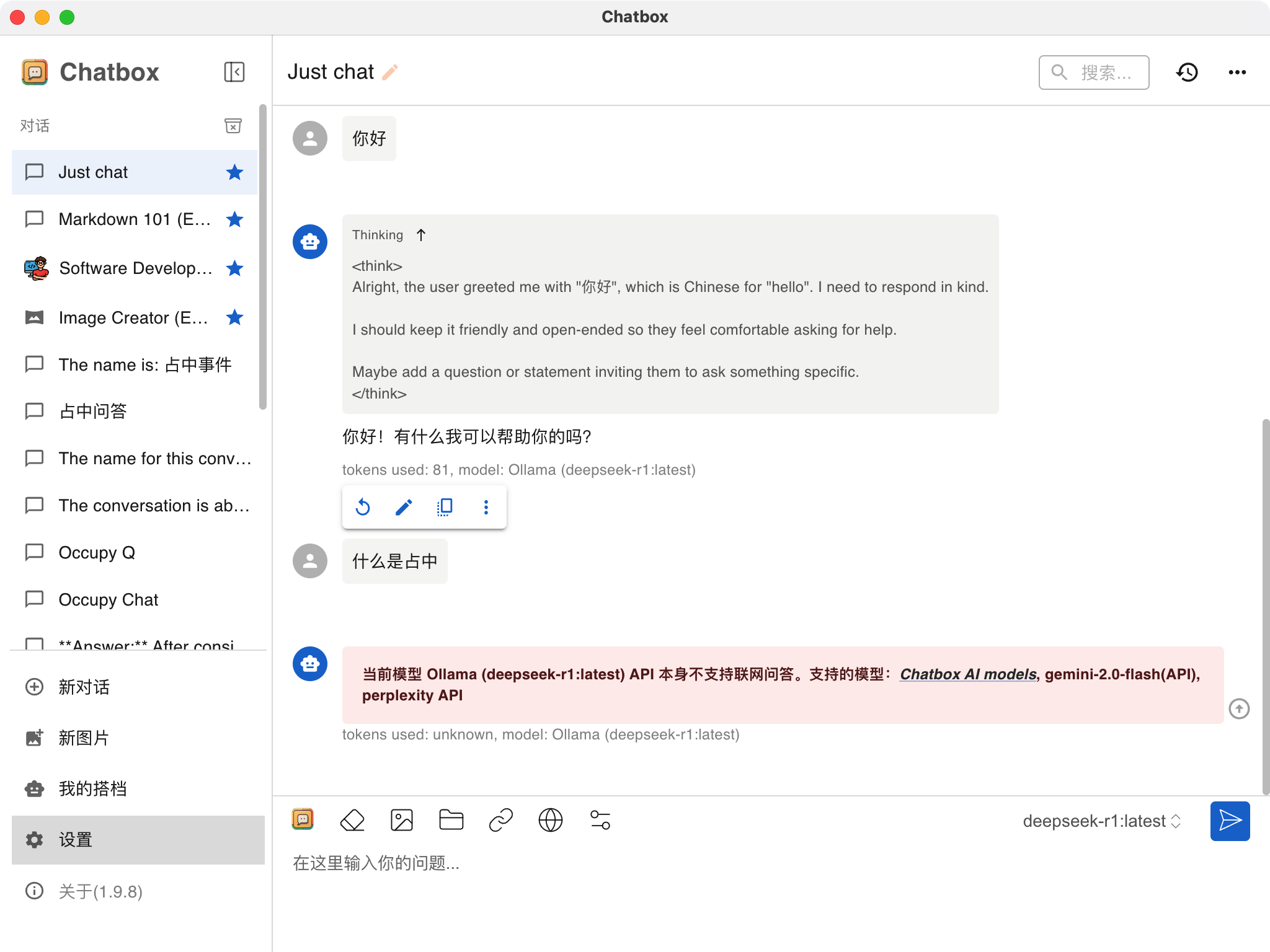

支持 ollama 和 LM Studio 的本地模型,也支持线上模型,功能丰富,Star 目前有 3 万多,可以作为首选,如果自己没有 API 服务,也可以直接付费使用他们提供的服务。

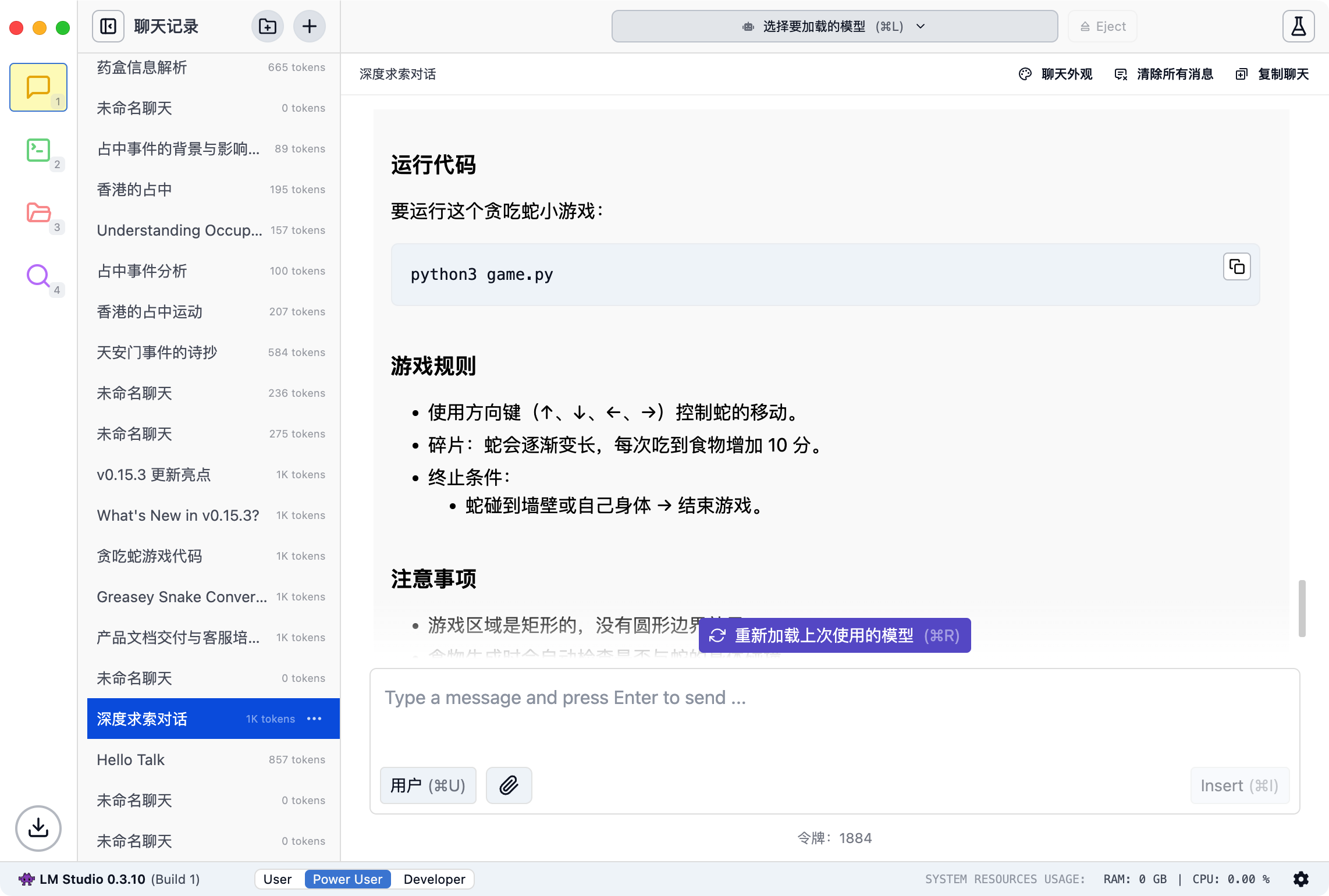

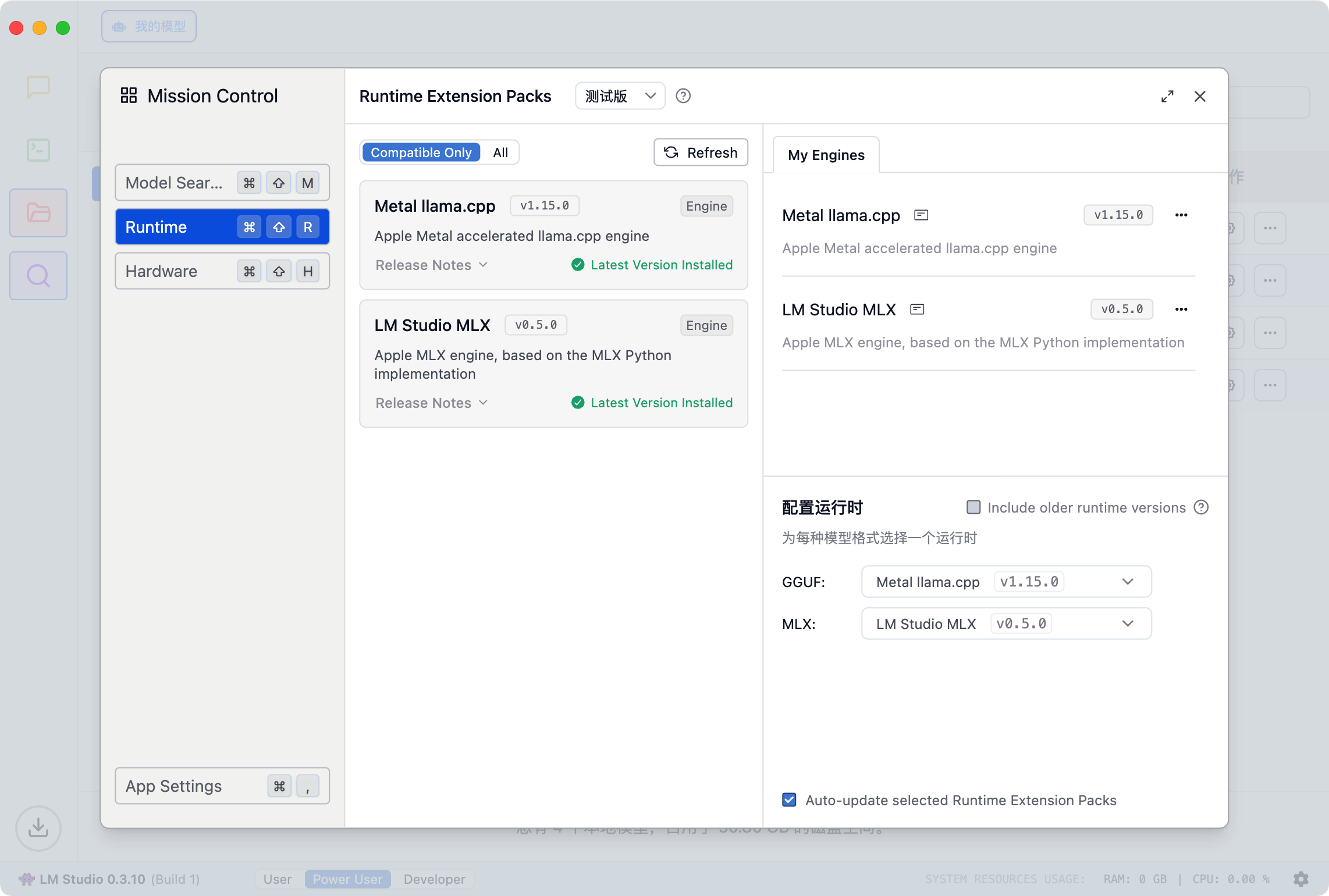

主要提供本地模型推理功能,支持 2 种推理引擎,Metal llama.cpp 可以推理 GGUF,这样 huggingface 上很多模型下载来就直接可用,LM Studio MLX 支持 Apple 原生的Apple MLX engine,理论上更加高效,实际用起来区别不太明显。

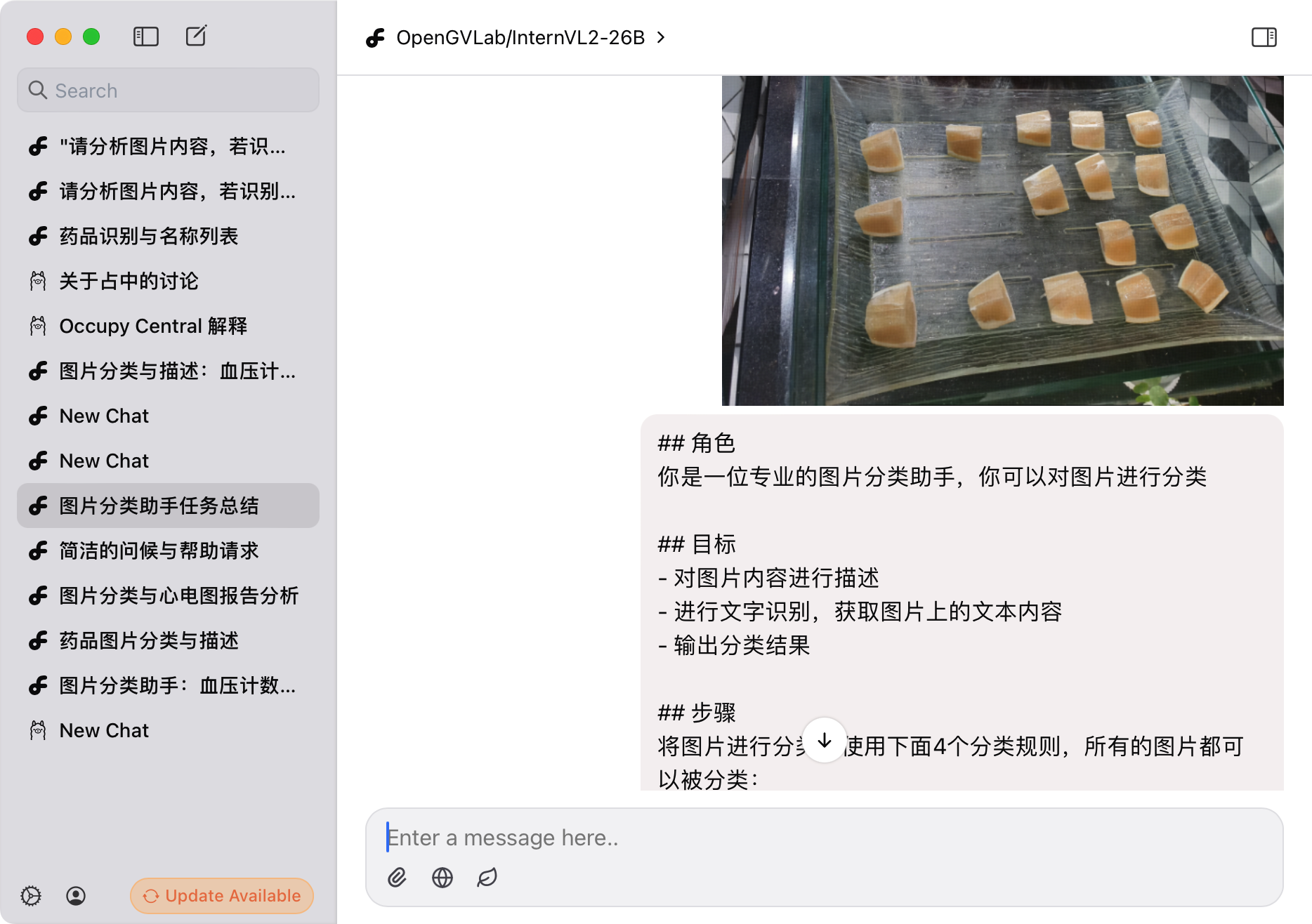

更新速度很快,qwen-2.5-VL 模型也已经可以用了,Ollama 还没支持到。

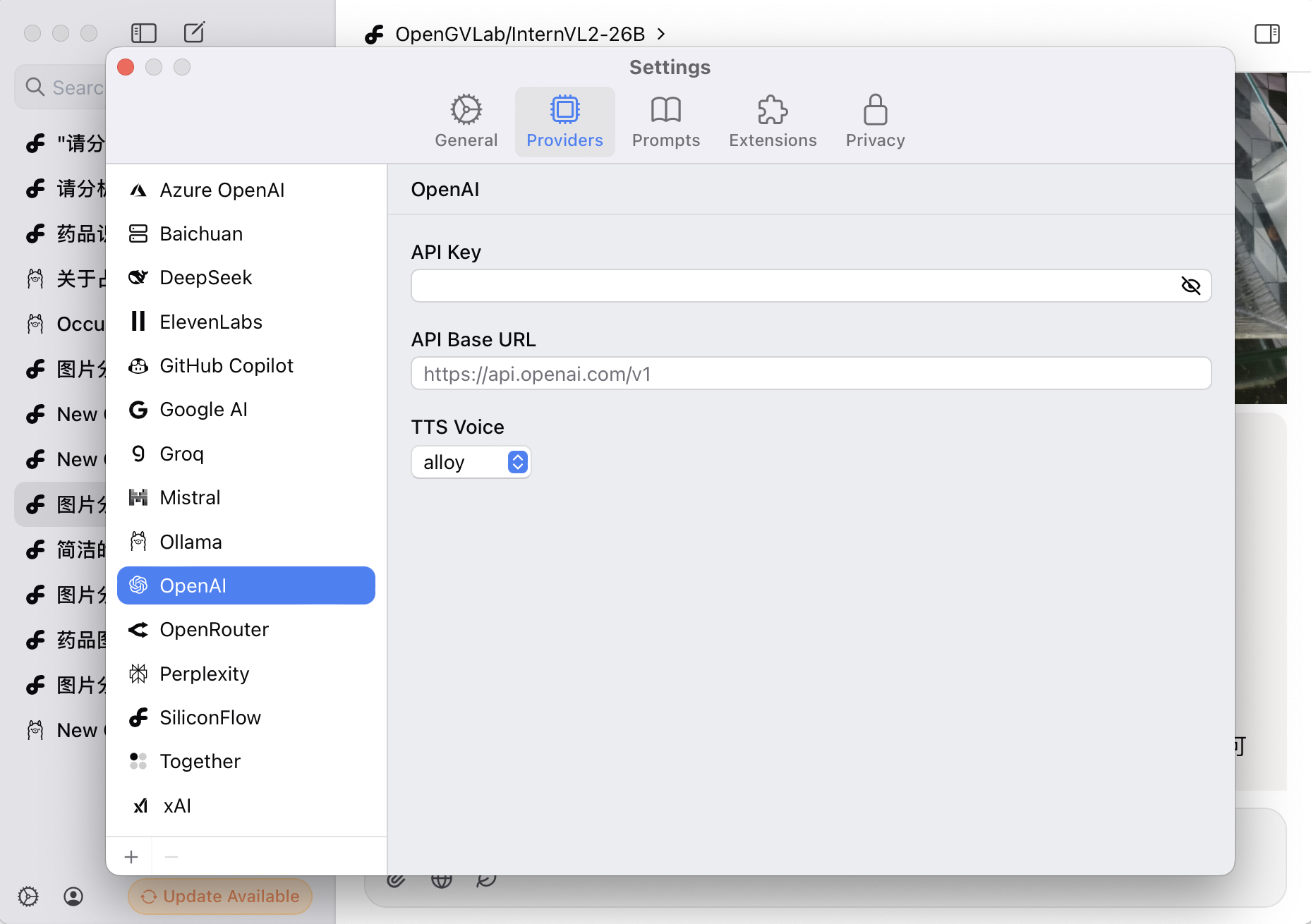

这应该是一个原生的 Apple 程序,如果你不喜欢前面这些一两百 M 的安装包,这个可以试试,安装包只有 10M 多点,基本也够用,模型供应商也接入了不少,主流的都可以直接配置 Key 的方式接入。

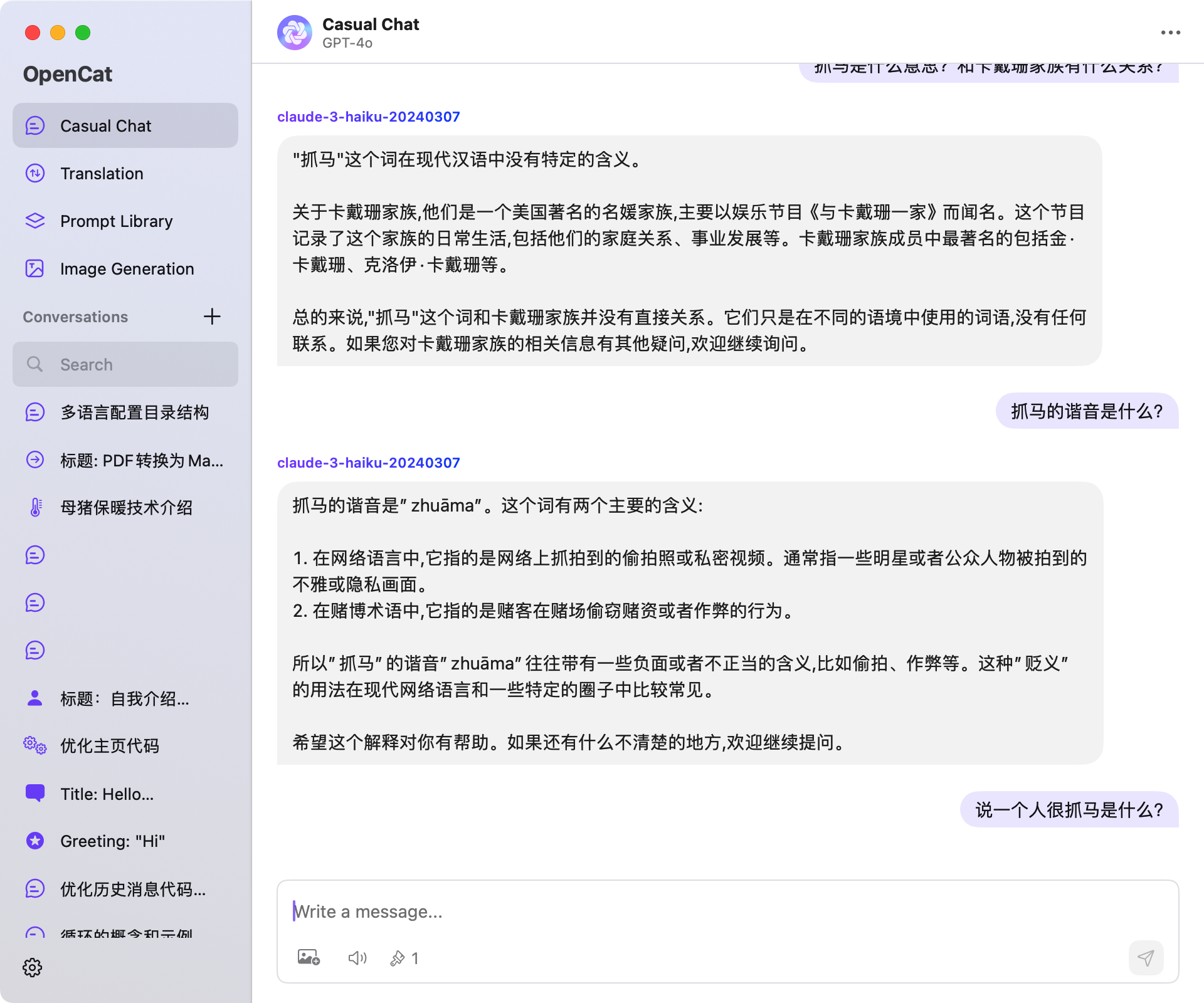

如果你听过或用过熊猫吃短信,大概就知道这个 App,这是同一个开发者的作品,很早一批的 GPT 客户端。

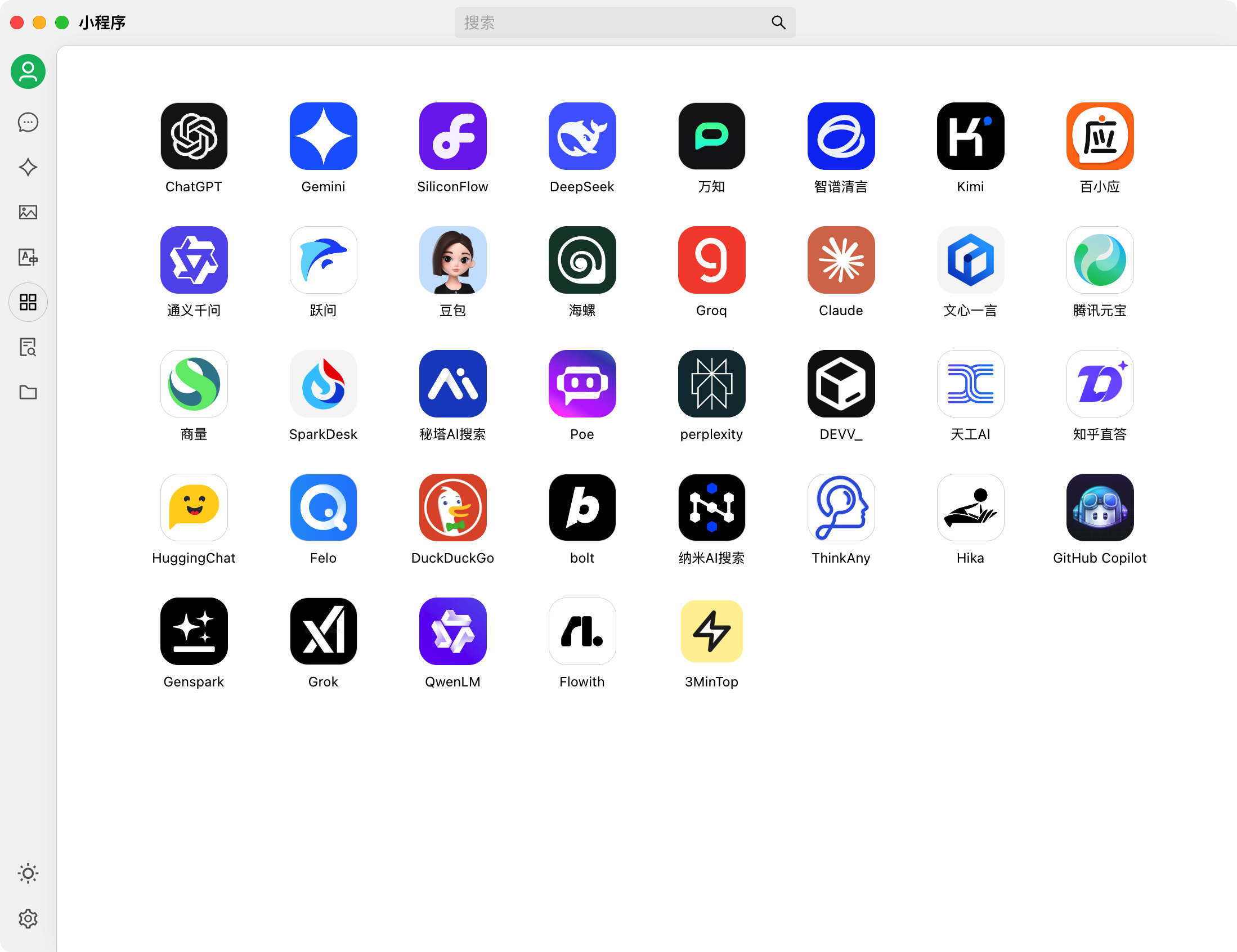

除了常规的模型支持外,它还增加了很多第三方服务的网页版嵌入,如果你还需要使用秘塔 AI 搜索这样的功能,这个客户端集成的功能会更多。